基于高光譜成像的大豆食心蟲小樣本檢測方法研究3

發(fā)表時間:2023-07-14 16:59

本研究應(yīng)用了400-1000nm的高光譜相機,可采用杭州彩譜科技有限公司產(chǎn)品FS13進行相關(guān)研究。光譜范圍在400-1000nm,波長分辨率優(yōu)于2.5nm,可達1200個光譜通道。采集速度全譜段可達128FPS,波段選擇后最高3300Hz(支持多區(qū)域波段選擇)。

大豆為我國主要糧作物之一,同時也是我國進口量最大的農(nóng)產(chǎn)品之一,其在食品、飼用、醫(yī)藥和工業(yè)等方面都有著重要的地位。大豆的品質(zhì)檢測是在大豆交易和流通中的一個重要環(huán)節(jié),同時大豆蟲害是嚴重影響大豆品質(zhì)的重要因素。其中大豆食心蟲是一種頻發(fā)的蟲害,嚴重影響大豆的品質(zhì)和質(zhì)量。目前,大豆品質(zhì)檢測大多還停留在人工肉眼觀測和化學(xué)分析檢測方法上面,少量研究將高光譜技術(shù)結(jié)合機器學(xué)習(xí)應(yīng)用于病蟲害的無損檢測。人工檢測比較主觀,準確率和效率低下;化學(xué)檢測時間周期長,破壞樣本;圖像處理檢測則需要大量樣本訓(xùn)練判別模型,且這些方法很難直接移植到大豆食心蟲蟲害檢測領(lǐng)域。本文旨在利用高光譜成像技術(shù),結(jié)合深度學(xué)習(xí)小樣本元學(xué)習(xí)思想實現(xiàn)對大豆食心蟲蟲害程度的無損檢測,實現(xiàn)在少量樣本下的高精度檢測,在舍去昂貴的樣本標注費用和時間的同時達到優(yōu)異的檢測成果,具有一定的社會價值,同樣該方法的思想對于別的檢測領(lǐng)域也有借鑒價值。主要研究工作和貢獻如下∶

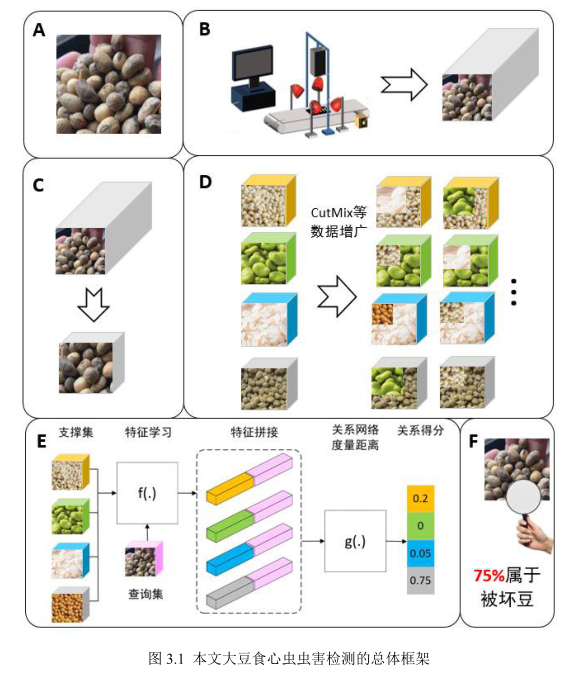

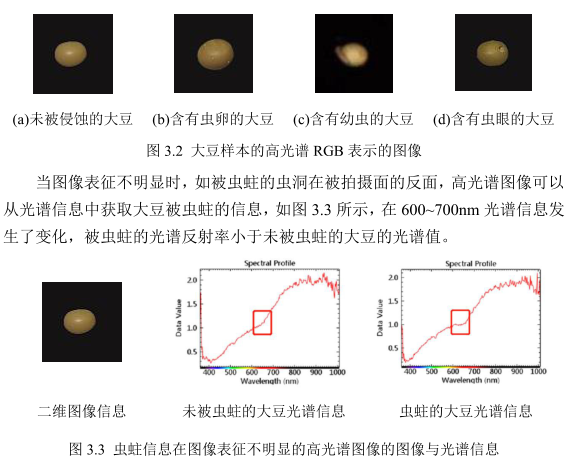

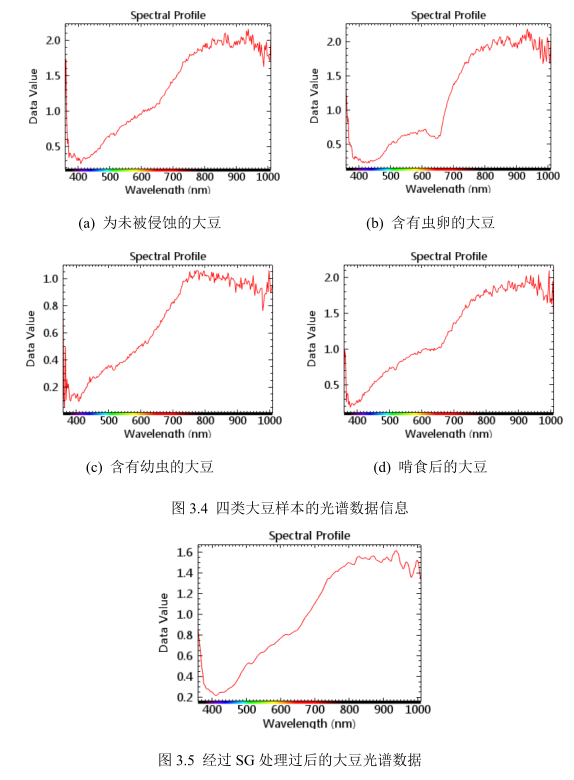

本研究針對大豆食心蟲蟲害進行無損檢測,應(yīng)用高光譜圖像結(jié)合小樣本元學(xué)習(xí)分類算法,對貯存期的大豆受大豆食心蟲侵蝕程度的無損檢測進行初步研究。本論文只要完成的工作如下∶ (1)提出了基于三維關(guān)系網(wǎng)絡(luò)小樣本元學(xué)習(xí)算法的大豆食心蟲蟲害高光譜檢測方法。本文提出了針對高光譜圖像分類的三維關(guān)系網(wǎng)絡(luò)元學(xué)習(xí)模型(3D-RN),能夠在實驗對象樣本數(shù)量稀少的情況下對高光譜圖像進行分類檢測。本文利用高光譜成像技術(shù)采集含有蟲卵的,含有食心蟲幼蟲的,被啃食的及正常的大豆的高光譜圖像,并對采集得到的高光譜圖像采用黑白校正和Savitzky-Golay(SG)濾波算法預(yù)處理高光譜圖像的光譜信息,在采用主成分分析法(PCA)選取貢獻最大的前9個特征波長從而降低高光譜圖像的維度。通過使用CutMix數(shù)據(jù)增廣方法增加元訓(xùn)練集的數(shù)據(jù),從而增加模型的先驗知識,使得模型性能更優(yōu)。并將Gradual WarmUp 方法實踐于高光譜圖像分類領(lǐng)域,優(yōu)化了模型的學(xué)習(xí)率,使得模型更加的穩(wěn)定。最后建立模型無關(guān)元學(xué)習(xí)(MAML),匹配網(wǎng)絡(luò)元學(xué)習(xí)(MN),原型網(wǎng)絡(luò)元學(xué)習(xí)(PN)和本文提出的三維關(guān)系網(wǎng)絡(luò)元學(xué)習(xí)(3D-RN)四個小樣本元學(xué)習(xí)算法的大豆食心蟲蟲害程度檢測模型。實驗結(jié)果表明,3D-RN模型表現(xiàn)最好,在學(xué)習(xí)率為0.01,元訓(xùn)練集個任務(wù)數(shù)據(jù)中各類的支撐集數(shù)據(jù)為5的情況下,準確率可達82±2.50%。 (2)提出了基于 A-ResNet 元學(xué)習(xí)模型的大豆食心蟲蟲害高光譜檢測方法。實驗利用高光譜成像系統(tǒng)采集正常的以及受大豆食心蟲侵害的大豆高光譜圖像,并使用黑白校正,SG平滑方法以及PCA方法預(yù)處理高光譜圖像,并提取圖像的感興趣區(qū)。采用CutMix等方法增加數(shù)據(jù)集樣本量。本文為了進一步提高大豆食心蟲蟲害檢測模型的準確率,針對3D-RN模型的弊端,本文提出了A-ResNet元學(xué)習(xí)模型,該模型將ResNet 網(wǎng)絡(luò)與Attention思想相結(jié)合,獲取更加能夠表述樣本的特征向量以此來提升模型性能。并舍棄了特征拼接的步驟,減少了模型的運行時間,并且簡化了分類模型,將分類模型設(shè)計為多分類支持向量機,來減少模型中出現(xiàn)的過擬合現(xiàn)象。實驗將A-ResNet元學(xué)習(xí)模型的結(jié)果與MAML、MN、PN 和 3D-RN 模型進行比較。實驗表明,A-ResNet 元學(xué)習(xí)模型在5-shot 情況下的表現(xiàn)最好,準確率達到94.57±0.19%。 |